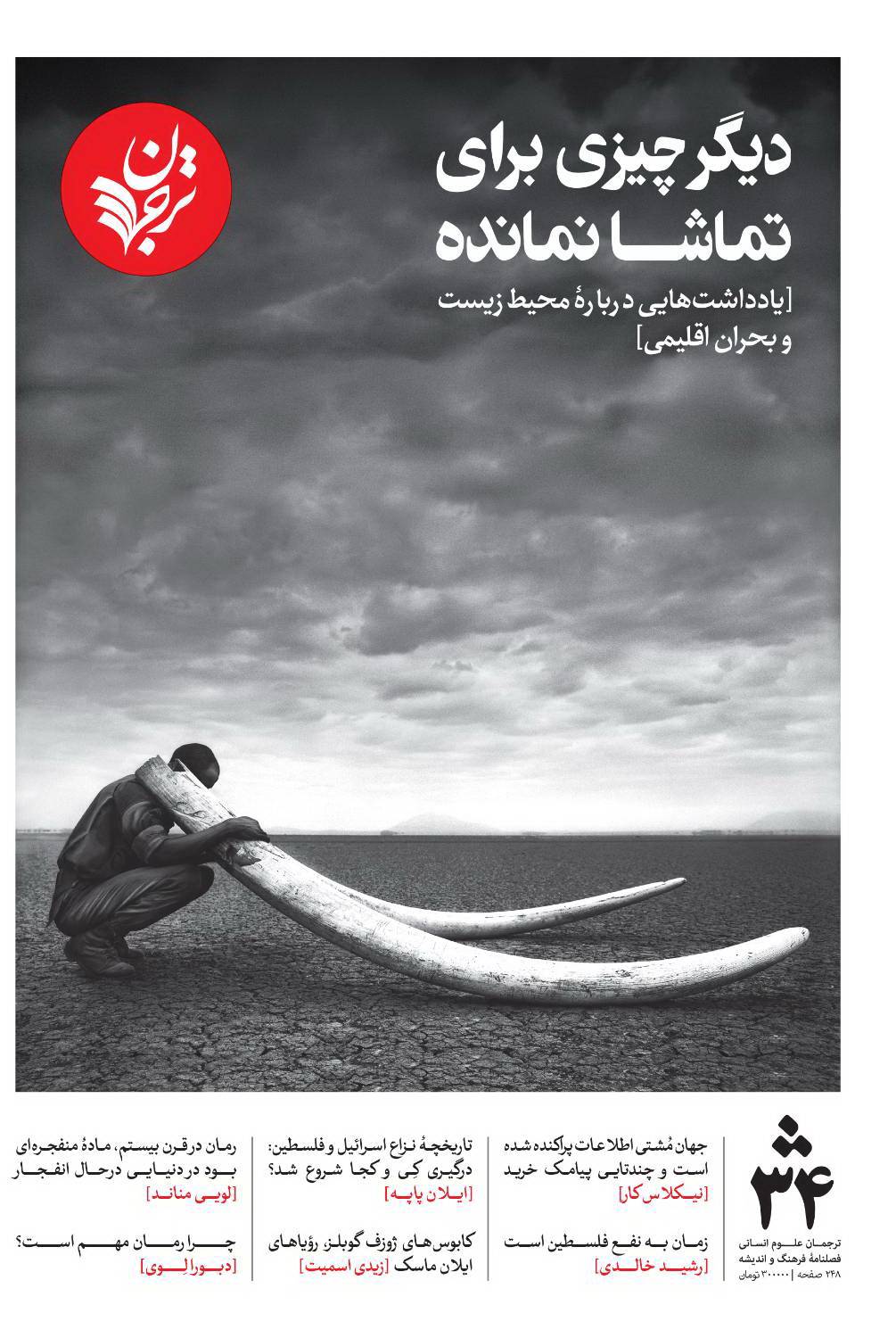

مدلهای ریاضیاتی به منزلۀ سلاحهای کشتار جمعی

الگوریتمهای نامرئی و همهجا حاضر، در حال نابود کردن زندگی میلیونها نفر هستند

تصویرساز: ناتالی لیز.

تصویرساز: ناتالی لیز.

اگر میخواهید بدانید «سلاح کشتار ریاضی» یعنی چه، این سناریو را تصور کنید: یک روز صبح، شما را به اتهام قتل دستگیر میکنند. سوار ماشین پلیس میشوید، و وقتی بعد از ۱۰دقیقه به دادگاه میرسید، حکمِ نهایی را به دستتان میدهند. هوش مصنوعی در این ۱۰دقیقه، با استفاده از کلاندادهها سوابق کیفری شما، الگوهای روانشناختیتان، روابطتان با دیگران، جزئیات ماجرا و هر چیز دیگری را مرور کرده و شما را گناهکار تشخیص داده است. نه نقطۀ مبهمی وجود دارد، نه کسی حوصلۀ شنیدن حرفهایتان را دارد. چه حالی خواهید داشت؟

Weapons of Math Destruction: invisible, ubiquitous algorithms are ruining millions of lives

14 دقیقه

کوری دکترو، بوینگ بوینگ — سالهاست که دربارۀ کارهای کتی اونیل، [ملقب به] «مثبِیب»۱، مینویسم. او دانشمند علوم داده است و دکترایش را از هاروارد گرفته، و اصطلاح سلاحهای کشتار ریاضی را وضع کرده تا نشان دهد مدلسازیهای بیقید آماری، هرروزه، دمار از روزگار میلیونها نفر درمیآورند، و زندگیهای بیشتر و بیشتری را به نابودی میکشانند. اونیل حالا کتابی منتشر کرده و عنوانی خارقالعاده، بیپرده و مبارزهطلبانه (دیگر چه میخواهید؟) برآن نهاده: سلاحهای کشتار ریاضی۲.

•••

بحثها دربارۀ نقش مهداده۳ در جامعۀ ما بیشتر متمایل است تا بر روی الگوریتمها تمرکز کند، بااین حال، الگوریتمها به خوبی کار میکنند و تأثیرشان بر مدیریت مجموعههای عظیم داده مشخص شده است. مسئله اصلی الگوریتمها نیستند، بلکه مدلها هستند. وقتی به یک الگوریتم داده میدهید و از آن میخواهید براساس دادهها برایتان پیشبینی انجام دهد، به شما یک مدل تحویل میدهد. آنطور که اونیل میگوید، «مدلها درست مانند نظرات کارشناسی هستند که در تاروپود ریاضیات تنیده شدهاند».

دیگر دانشمندان داده منتقد، مانند پاتریک بال از «گروه تحلیل داده حقوق بشر» نیز انتقادشان را از همین زوایه وارد کردهاند. پاتریک یکبار برای من توضیح داد که میتوانید یک الگوریتم را به نحوی آموزش دهید که قد افراد را براساس وزنشان پیشبینی کند، اما اگر همۀ دادههایی که برای آموزش الگوریتم استفاده میکنید مربوط به کلاس سومیها باشد، و آنهایی را هم که وزن خودشان را میدانند، مستثنی کنید، آنوقت مدل شما پیشبینی میکند که قد بیشتر افراد تقریباً صد و بیست سانتیمتر است. مشکلْ الگوریتم نیست، بلکه از یک سو دادههایی است که برای آموزش آن به کار میروند، و از سوی دیگر، نبودِ سازوکاری برای اصلاح خطا در نتیجهگیری.

اونیل نیز، مانند بال، مشتاق است مدلسازیِ برآمده از داده، تبدیل به نیرویی خیر در جهان شود، و بازهم مانند بال، این مسئله ناامیدش میکند که میبیند کارهای بیقید آماری میتوانند با نقاب عینیگرایی ریاضی، و به بهای از بین بردن زندگی میلیونها نفر، سودی سرشار نصیب چند شرکت کنند.

اونیل این مدلهای خطرناک را «سلاحهای کشتار ریاضی» مینامد، اما، در عین حال، اینطور نیست که همۀ مدلهایی که خطا دارند، در این دسته قرار بگیرند. برای آنکه یک مدل در زُمرۀ «سلاحهای کشتار ریاضی» جای بگیرد، باید برای افرادی که تحت آن مدل قرار میگیرند، فهمناپذیر باشد، به منافعشان آسیب برساند، و به شکلی تصاعدی رشد کند تا به مقیاسی بسیار بزرگ برسد.

امروزه این مدلها را همهجا میتوان یافت. نظام آموزشیِ رسوا و سودمحور ما متوجه شده است که چگونه از مدلها برای شناسایی آدمهای مأیوس استفاده کرده و آنها را فریب دهد تا پایشان را به «دورههای» آموزشی گرانقیمتی باز کند که میباید شهریهاش را با وامهای دانشجویی سرسامآوری پرداخت کنند که تحت حمایت دولت فدرال است. به این دلیل است که دانشگاه فونیکس، حتی باوجود بیش از ۱ میلیارد دلار هزینۀ تبلیغات در سال، باز هم میتواند اینچنین سودآور باشد. علیرغم این واقعیت که هزینه بازاریابی آنها ۲.۲۲۵ دلار به ازای هر دانشجو است، و تنها ۸۹۲ دلار به ازای هر دانشجو، خرج آموزش میکنند، اما سلاح کشتار ریاضیای ساختهاند که دانشجویان را به تعداد زیاد و با سرعت بالا برایشان شکار میکند. درهمین حال، دانشگاههای کوچکی که هزینۀ کمتر و کارایی بیشتری دارند، در لابهلای جار و جنجالهای تبلیغاتی دانشگاه فونیکس عملاً گم میشوند.

یکی از آشکارترین ویژگیهای سلاحهای کشتار ریاضی، فقدان بازخورد و تنظیم است. در ورزش، تیمها از مدلهای جزئینگر آماری برای پیشبینی این موضوع استفاده میکنند که کدام ورزشکار را باید خریداری کنند و هنگام آمادگی برای مسابقه، چگونه آنها را به کار گیرند. اما پس از آنکه مسابقه برگزار شد، تیمها مدلهایشان را روزآمد میکنند تا شکستهایشان را تبیین کنند. اگر دست رد به سینۀ بازیکن بسکتبالی بزنید و او به تیم رقیب شما بپیوندد و در آنجا افتخارآفرینی کند، مدلتان را روزآمد میکنید تا در فصل بعدی نقل و انتقالات عملکردی بهتر داشته باشید.

همین را مقایسه کنید با استفاده هرروزه از سلاحهای کشتار ریاضی علیه ما. بزرگترین کارفرمایان در امریکا از سرویسهای تجاری برای سنجش رزومههای دریافتیشان با مدل کارمند «موفق» استفاده میکنند. آیندۀ شغلی شما در دستان این مدلهاست. اگر یکی شما را رد کند، و بعد به جای دیگری بروید و در آنجا عملکردی عالی داشته باشید، باز هم این واقعیت هیچگاه برای اصلاح مدل به کار نمیرود. همه بازندهاند؛ کارجویان به اجبار از بازارکار کنار گذاشته میشوند، و کارفرمایان هم نیروهای عالی را از دست میدهند. در این میان، تنها تاجران سلاحهای کشتار ریاضی هستند که، همچون راهزنها، به نان و آب میرسند.

ارزشش را دارد که بپرسیم چگونه به اینجا رسیدیم. بسیاری از سلاحهای کشتار ریاضی بهمنزلۀ پاسخی برای خطاهای ساختاری به کار گرفته شدند؛ برای مثال در صدور رأی قضایی، درجهبندی مدارس، پذیرش دانشگاهها، استخدام، و ارائۀ تسهیلات. قرار بود مدلها عاری از سوگیریهای جنسی و نژادی باشند، و امتیازات و ارتباطات افراد نیز در عملکرد آنها تأثیری نداشته باشد.

اما متأسفانه، در اغلب موارد، مدلها با دادههایی طراحی میشوند که سوگیری دارند. تصویر دانشجویان موفق آینده در دانشگاههای برتر، یا وامگیرندهای که اقساطاش را به موقع پرداخت میکند، بر اساس دادههایی ترسیم میگردد که برآمده از سابقۀ پر از سوگیری مؤسسه هستند. اطلاعات تمام فارغالتحصیلان هاروارد، یا همۀ وامگیرندگان وظیفهشناس، به الگوریتمی داده میشود که چشم بسته پیشبینی میکند دانشجویان فردای هاروارد یا وامگیرندگانی که اولویت دارند، درست شبیه به دیروزیها باشند؛ فرقش این است که حالا دیگر سوگیریها از مزیت عینیبودن هم برخوردارند.

این مشکل به خوبی در آمار شناخته شده است، اما دلالان سلاحهای کشتار ریاضی نادیدهاش میگیرند. درمقابل، شرکتهایی که خودشان برنامههای مهدادهشان را طراحی و اجرا میکنند، بیشتر مراقب اصلاح مدلهایشان هستند. شرکت آمازون با دقت، مشتریانی را رصد میکند که دیگر از کارتهای خرید این شرکت استفاده نمیکنند، یا بعد از یکی دو خرید، قید خرید را میزنند. آنها علاقهمندند همهچیز را دربارۀ «ارتکاب مجدد»۴ خریدارانشان بدانند، و به همین دلیل مدلسازیهای آماری را با انسانشناسی -برای فهمیدن و صحبتکردن با خریداران- تلفیق میکنند تا سیستم خودشان را بهتر کنند.

تفاوت این سیستم با نرمافزاهای خودکار صدور رأی -که اکنون به شکلی گسترده در نظام قضایی ایالت متحده به کار میروند و دارند به سرعت در همه جای دنیا فراگیر میشوند- دیگر از این آشکاتر نمیتواند باشد. شرکتهایی که اپلیکیشنهای صدور رأی را میفروشند نیز، مانند دانشمندان علوم دادۀ آمازون، میکوشند وقوع مجدد جرم را پیشبینی کنند، و پیشبینیهایشان ممکن است یک فرد را دههها به زندان بفرستد و فردی دیگر را آزاد کند.

اما این دلالها مدلهایشان را براساس دادههای معیوب گذشته طراحی میکنند. رأیهای نژادپرستانۀ گذشته را مینگرند؛ یعنی رأیهایی که مردان جوان سیاهپوست را به جرم همراهداشتن اندکی کراک به زندان میفرستادند، درحالیکه کاری به کار مردان سفیدپوست پولداری که کوکایین حمل میکردند نداشتند، و «پیشبینی» میکنند اهالی مناطق فقیرنشین، که از قضا سروکار دوستان و اعضای خانوادهشان هم به پلیس افتاده بوده، دوباره قانونشکنی خواهند کرد. بدینترتیب برایشان احکامی طولانی مدت توصیه میکنند تا از جامعه دور نگهشان دارند.

این شرکتها، برخلاف آمازون، به دنبال این نیستند که بدانند آیا محکومیت طولانیتر (با ایجاد آسیب روحی و انزوای اجتماعی) از دلایل ارتکاب مجدد جرم است یا خیر. وانگهی، تمایلی ندارند بدانند آیا کتکخوردن، حبس انفرادی و تجاوز در زندان ارتباطی با ارتکاب مجدد جرم دارند یا نه. اگر زندان همانند شرکت آمازون اداره میشد؛ یعنی با تعهد به کاهش ارتکاب مجدد جرم، به جای تعهد به عدالت (که مورد علاقه پیمانکاران سیستم قضایی و متعصبان تشنۀ انتقام در حوزههای انتخاباتی است) احتمالاً شبیه به سبک زندانداری نروژی میشد؛ یعنی زندانی انسانی، کمجمعیت، با هدف بازپروری، درمان اعتیاد، آموزش شغلی، و مشاورۀ روانشناختی.

سلاحهای کشتار ریاضی، آموزش را، هم برای معلمان و هم دانشآموزان، تغییر دادند. در دهۀ ۱۹۸۰، دولت ریگان گزارشی به نام «کشوری در خطر» را دستاویز قرار داد که ادعا میکرد ایالات متحده، به دلیل افت نمرات آزمون اساِیتی۵، در آستانه فروپاشی است. این گزارش، آغاز حملهای همهجانبه به معلمان و آموزش عمومی بود که تا امروز نیز ادامه دارد.

بارزترین تجلی این موضوع، ارزیابی «ارزش افزودۀ» معلمان است که با استفاده از مجموعهای از آزمونهای استاندارد، عملکرد معلمان را سال به سال اندازهگیری میکند. خطاهای آماری این ارزیابیها خندهدار است (آمار روی اعداد بزرگ جواب میدهد، نه کلاسی با ۲۵ کودک؛ ارزیابیها ممکن است از یک سال تا سال دیگر ۹۰ درصد تغییر کنند، و تفاوت چندانی با دادهسازی ندارد). معلمان؛ معلمان خوب و متعهد، با این آزمونها شغلشان را از دست میدهند.

درهمینحال دانشآموزان هم، برای آنکه بتوانند بیشتر و بیشتر تست بزنند، از یادگیری واقعی دور میشوند، و همین تستها که قرار بود استعدادهای آنها را بسنجد -و بنابراین نمیبایست تابع دورههای گرانقیمت آمادگی برای آزمون میبودند- تمام آیندهشان را تعیین میکند.

به هرحال مشخص شد گزارش «کشوری در خطر» نیز که آغازگر این ماجرا بود، از بیخ و بن چرند است و خطاهای آماری خندهداری دارد. مرکز تحقیقات سندیا بعدها یافتههای گزارش را ممیزی کرد و متوجه شد پژوهشگران نتوانستند توضیحی برای تعداد فزایندۀ «دانشآموزانی پیدا کنند که آزمون اسایتی میدادند» و بدین ترتیب باعث پایین آمدن نمرۀ میانگین میشدند.

به بیان دیگر، نتایج اسایتی به این دلیل افت میکرد که «بچههای امریکایی بیشتری اعتماد به نفسِ رفتن به دانشگاه را داشتند»: نظام آموزشی «آنقدر خوب» کار میکرد که افراد جوانی که هیچوقت فکر شرکت در اسایتی را هم نمیکردند، در آن ثبتنام کردند و تعداد زیاد آزموندهندگان داشت نمرۀ میانگین را کاهش میداد.

سلاحهای کشتار ریاضی، سراسرِ زندگی انسان را تبدیل به بازیای برای بهبود موتورهای جستجو میکنند. سوداگران، در این زمانۀ «سئو»، شرکتهایی را به استخدام درمیآورند که ادعا میکنند الگوهای پیچیدۀ گوگل را مهندسی معکوس کردهاند و ترفندهایشان میتواند رتبۀ سایت شما را بهتر کند.

زمانی که هزاران دلار پول میدهید تا یک نفر فرزندتان را برای آزمون اسایتی آماده کند، یا رتبۀ سایتتان را با کمک خدماتدهندههای «امتیاز الکترونیکی»۶ بالا ببرد تا شایستگی شما را برای تخصیص اعتبار، یافتن کار یا گرفتن وام تعیین کنند، درواقع دارید سئو را در تمام ابعاد زندگی خودتان بازآفرینی میکنید. تصویر تیره و تار آینده چنین است: تولیدکنندگان سلاحهای کشتار ریاضی و کارشناسان سئو به مسابقۀ تسلیحاتی بیپایانی افتادهاند تا مدلهایشان را بهتر کنند و به مصاف یکدیگر بروند، و بقیۀ ما دستخوش بوالهوسیهای الگوریتمهای خودکار، یا باجدادن برای فرار (موقت) از آنهاییم. در آینده، ما دیگر مصرفکننده نیستیم، بلکه خودمان محصولیم (شهروند که هیچ).

کار اونیل مهم است چراکه او به علوم داده ایمان دارد. الگوریتمها را میتوان برای یافتن افرادی به کار بست که با مشکلات دست و پنجه نرم میکنند؛ معلمانی با چالشهایی دشوار، افرادی در تنگنای مالی، آنهایی که در شغلشان تقلا میکنند و دانشآموزانی که به توجه آموزشی نیاز دارند. این دیگر به ما بستگی دارد که چنین اطلاعاتی را درجهت نادیدهگرفتن و بیشتر قربانیکردنشان به کار بندیم، یا به آنها از طریق تخصیص منابع بیشتر کمک کنیم.

واحدهای اعتبارسنجی، امتیازات الکترونیک، و دیگر موجودیتهایی که ما را در قالب مدلها جا میدهند، با نوعی اثباتگرایی دروغین، آسیبهایی جبرانناپذیر بر ما وارد میکنند؛ از لیستهای پرواز ممنوع۷ گرفته، تا خطاهای اعتبارسنجی و خطاهای ارزیابی شغلی که به بهای ازدستدادنِ کارمان تمام میشود. این خطاها برای آنها هزینۀ چندانی ندارد، اما برای ما بسیار گران تمام میشوند. هزینه زدودن چنین چیزهایی (پاکسازی سوابق منفی کاری، یافتن منزلی نو، سپریکردن دوران طولانیتر محکومیت و از این دست) مانند هزینۀ تبعات منفی۸، بسیار بالا است، اما ما این هزینهها را میپذیریم و آنها هم پساندازمان را درو میکنند.

اگر شعار ای پلوریبوس یونُم۹ را واژگون کنیم، چنین میشود: مدلها، بسیاری را از میان یکی بیرون میکشند، هرکداممان را بهعنوان عضوی از یک گروه طبقهبندی میکنند. گروههایی که میتوان به کمک آنها تعمیمدهی انجام داد؛ تعمیمهایی که اغلب نیز تنبیهی و کمرشکن هستند (مانند قیمتگذاری متغیر۱۰).

مدلسازی از میان نخواهد رفت؛ چراکه مدلها، به عنوان ابزارهایی برای راهنمایی و مراقبت و همچنین به عنوان سیستمهایی مفید و چارهساز، فوقالعادهاند، اما اگر همچون ابزاری برای تنبیه و تضعیف به کار روند، تبدیل به کابوس میشوند. انتخابش با ماست. کتاب اونیل مانند یک دوره به زبانِ ساده است که پیرامون دانش آماری تخصصی نوشته شده است؛ دانشی که همۀ ما برای پرسشگری از سیستمهایی که دورتادورمان را گرفتهاند، و همچنین برای مطالبهگری از آنها، بدان نیاز داریم.

اطلاعات کتابشناختی:

O’neil, Cathy. Weapons of math destruction: How big data increases inequality and threatens democracy. Broadway Books, 2016

پینوشتها:

• این مطلب را کوری دکترو نوشته است و در تاریخ ۶ سپتامبر ۲۰۱۶ با عنوان «Weapons of Math Destruction: invisible, ubiquitous algorithms are ruining millions of lives» در وبسایت بوینگ بوینگ منتشر شده است. وبسایت ترجمان آن را در تاریخ ۳۱ شهریور ۱۳۹۸ با عنوان «مدلهای ریاضیاتی به منزلۀ سلاحهای کشتار جمعی» و ترجمۀ آرش رضاپور منتشر کرده است.

•• کوری دکترو (Cory Doctorow) روزنامهنگار و نویسندۀ ژانر علمی-تخیلی است. دکترو مؤسس و یکی از نویسندگان اصلی وبلاگ مشهور بوینگ بوینگ است که دربارۀ تأثیرات تکنولوژی بر زندگی روزمره بحث میکند. برادر کوچک (LITTLE BROTHER) از کتابهای اوست.

[۱] Mathbabe: دختر ریاضی

[۲] این عنوان شباهت خیلی نزدیکی به تعبیر سلاحهای کشتار جمعی (Mass destruction Weapons)دارد و در واقع کنایهای برای آن است [مترجم].

[۳] Big data

[۴] Recidivism: در اصل تمایل مجدد مجرمان برای تکرار اعمال مجرمانه، حتی پس از آزادی از زندان [مترجم].

[۵] SAT: آزمونی استاندارد در ایالات متحده که بویژه برای ورود به دانشگاه کاربرد دارد [مترجم].

[۶] e-score: شاخصی برای رتبهبندی مشتریان که ارزش احتمالی مشتری را بر حسب درآمد، اشتغال، ارزش خانه و مانند آنها تعیین میکند تا بدین ترتیب برنامههای بازاریابی هدفمندتر انجام گیرند. فعالیت اصلی برخی شرکتها، تهیه این شاخص و فروش آنها به شرکتهای دیگر است [مترجم].

[۷] The no fly list: لیست افراد مضنون به تروریسم که نمیتوانند به، از، یا برفراز قلمرو ایالات متحده پرواز کنند [مترجم].

[۸] negative externalities: به زیانهایی گفته میشود که متوجه فرد ثالث است، برای نمونه، شرکتهای تولید کننده الگوریتم و شرکتهایی که الگوریتم را برای غربالگری به کار میبرند (یعنی تولید کننده و مصرف کننده محصول) هر دو سود میکنند، اما افراد عادی که تحت الگوریتم قرار میگیرند، زیان میبینند [مترجم].

[۹] E Pluribus Unum: عبارت لاتین که معنای تحتاللفظیاش این است: «یکی از میان بسیاری». اشاره به سیزده مستعمرهنشین بریتانیا دارد که در قرن هجدهم اعلام استقلال کرده و ایالات متحده را تشکیل دادند. این عبارت روی بسیاری از سکهها و همچنین نشان بزرگ ایالات متحده نقش بسته است [مترجم].

[۱۰] variable pricing: یک استراتژی قیمتگذاری که براساس آن قیمت محصول متغیر و وابسته به عناصری مانند منطقه، نقطه فروش، نوع خریداران و غیره است [مترجم].