چرا نباید از هوش مصنوعی ترسید؟

گفتوگویی دربارۀ دشواری همتاسازی هوش انسانی در رایانهها

دلیل ترس فراگیر این روزها درخصوص هوش مصنوعی این تصور است که اگر الگوهای زبانی بزرگ را بهاندازۀ کافی با متن تغذیه کنیم، بدل به عاملهای هوشمندی خواهند شد که میتوانند جهان را درک و دریافت کنند. اما الیسن گوپنیک و ملانی میچل در مورد صحت این تصور تردید دارند و معتقدند هوش بسیار پیچیدهتر از آن است که فکر میکنیم و تا وقتی سیستمهای هوش مصنوعی نتوانند الگوهای ذهنیِ ویژۀ خودشان را از نحوۀ سازوکار جهان به وجود آورند، باید از انتساب هوش انسانی به آنها اجتناب کنیم.

ملانی میچل و الیسن گوپنیک

استاد انستیتو سانتا فه - استاد روانشناسی و فلسفه

How to Raise Your Artificial Intelligence: A Conversation with Alison Gopnik and Melanie Mitchell

28 دقیقه

گفتوگویی با ملانی میچل و الیسن گوپنیک، لسآنجلس ریویو آو بوکس— دلیل ترس و هیجان فزایندۀ این روزها در خصوص سیستمهای هوش مصنوعی این تصور است که وقتی پیشرفت کنند چیزی -یا شاید کسی- به وجود خواهد آمد: اگر الگوهای زبانی بزرگ (الالامها)1 را بهاندازۀ کافی با متن تغذیه کنیم، مشاهده خواهیم کرد که عملکردشان از تشخیص الگوهای آماری صِرف در دادهها فراتر خواهد رفت و بدل به عاملهای هوشمندی خواهند شد که میتوانند جهان را درک و دریافت کنند.

الیسن گوپنیک و ملانی میچل درمورد صحت این تصور تردید دارند. گوپنیک استاد روانشناسی و فلسفه است و دربارۀ آموزش و رشد کودکان مطالعه میکند؛ میچل استاد علوم رایانه و پیچیدگی2 است و مشخصاً درمورد انتزاع مفهومی و قیاس در سیستمهای هوش مصنوعی تحقیق میکند. آنها معتقدند هوش بسیار پیچیدهتر از آن است که فکر میکنیم. صحیح است که دستاوردهای الگوهای زبانی بزرگ بهواسطۀ مصرف مقادیر عظیم متن حیرتانگیز است -و برخی تصورات ما دربارۀ هوش را به چالش کشیدهاند- ولی تا وقتی سیستمهای هوش مصنوعی نتوانند با جهان پیرامون تعامل فعالانه کنند و الگوهای «ذهنیِ» ویژۀ خودشان را از نحوۀ سازوکار جهان به وجود آورند، باید از انتساب هوش انسانی به آنها اجتناب کنیم.

چگونه سیستمهای هوش مصنوعی میتوانند به این سطح پیشرفته برسند؟ ضامن پیشرفت ایمن آنها چیست؟ در گفتوگوی پیش رو، گوپنیک و میچل رویکردهای مختلف را بررسی میکنند، ازجمله برای نقش ما در مرحلۀ بعدِ پیشرفت هوش مصنوعی چارچوبی را مشخص میکنند که همان «مراقبت» است.

ژولیئن کراکت: اجازه دهید با مسئلۀ اصلیِ هوش مصنوعی آغاز کنیم. وقتی دربارۀ سیستمهای هوش مصنوعی فکر میکنیم یا حرف میزنیم، انگار هم ابزارهایی صِرف و هم بازیگرانی هوشمندند که یک روز زنده میشوند. الیسن تو گفتهای که سیستمهای هوش مصنوعی محبوب این روزها، الگوهای زبانی بزرگ، نه هوشمندند نه خنگ و نباید برای درک آنها به این دستهبندیها متوسل شویم، بلکه باید سیستمهای هوش مصنوعی را فناوریهایی فرهنگی، مثل ماشین چاپ یا اینترنت، در نظر بگیریم. چرا فکر میکنید «فناوری فرهنگی» چارچوب بهتری برای فهم الگوهای زبانی بزرگ است؟

الیسن گوپنیک: عموماً الگوهای زبانی بزرگ را عاملهای هوشمندی میدانند که با جهان تعامل میکنند و وظایفی را انجام میدهند. اشتباهی که اینجا رخ میدهد دستهبندی آنهاست. خیلی بهتر است آنها را فناوریهایی بدانیم که به انسانها امکان میدهند به اطلاعات بسیاری از انسانهای دیگر دسترسی داشته باشند و از آن اطلاعات در تصمیمگیریهایشان استفاده کنند. ما از اول بشریت همین کار را کردهایم. میتوان خودِ زبان را وسیلهای دانست که این امکان را فراهم میآورد. خط و اینترنت نیز همینطور. همۀ اینها راههای مختلفِ کسب اطلاعات از دیگران هستند. بههمینترتیب، الگوهای زبانی بزرگ یکی از شیوههای بسیار مؤثرِ دسترسی به اطلاعات سایر انسانها هستند. الگوهای زبانی بزرگ، عوض آنکه مثل انسانها بیرون بزنند، دنیا را ببینند و تصمیم بگیرند، اطلاعاتی را که آدمهای دیگر در اینترنت قرار دادهاند بهصورت دادههای آماری خلاصه میکنند.

باید توجه داشته باشیم که این فناوریهای فرهنگی نحوۀ سازوکار جوامعمان را شکل داده و دگرگون ساختهاند. نمیخواهم طوری حرف بزنم که انگار «هوش مصنوعی اهمیت خاصی ندارد». اهمیتِ فناوریهای فرهنگی جدید، مانند چاپ، از بسیاری جهات، بسیار بیش از عاملهای جدید، مثل عاملهای انسانی جدید، در جهان بوده است.

ملانی میچل: برای صحبت دربارۀ الگوهای زبانی بزرگ از استعارههای بسیاری استفاده میکنیم؛ «نسخۀ پیشرفتۀ کاملکنندۀ خودکار»3 و «طوطی اللهبختکی»4ازجملۀ آنها هستند. تِد چیانگ، نویسندۀ آثار علمیتخیلی، چتجیپیتی را «تصویرِ تارِ اینترنت» نامید. الیسن به آنها میگوید «فناوریهای فرهنگی». استعارههای دیگران بیشتر با عاملیت و فهم ارتباط دارند. فکر نمیکنم هیچکدام از این استعارهها مناسب باشند، چون الگوهای زبانی بزرگ، به یک معنا، همۀ اینها هستند. و شاید باید مشخص کنیم آنها تا چه اندازه با هر یک از این استعارات منطبقاند. در این مورد، بحث داغی میان متخصصان هوش مصنوعی درگرفته و جالب است که میبینیم چنین آدمهای باهوشی اینقدر درمورد این سیستمها اختلافنظر دارند. اما این اختلافنظرها بیانگر یکی از مضامین مکرر تاریخ هوش مصنوعی هستند: هوش مصنوعی برداشت ما از هوش را به پرسش میکشد.

در دهۀ ۱۹۷۰، خیلیها میگفتند اگر قرار باشد رایانه در سطح استادبزرگهای شطرنج ظاهر شود، باید هوش عمومی انسانی داشته باشد. ولی دیدیم که اینگونه نبود. درمورد ترجمه هم همین فکر را میکردیم. الان سیستمهایی را میبینیم که مکالمه میکنند و مثل عاملهایی رفتار میکنند که گفتوگوها را میفهمند. آیا این سیستمها مستلزم هوش انسانی هستند؟ ظاهراً خیر. پس شاید این مرحله هم صرفاً یکی از چالشهایی باشد که هوش موصنوعی بهواسطۀ آن فهم ما از هوش را شکل میدهد.

گوپنیک: مردم عادی (ازجمله آدمهای بسیار باهوشِ دنیای فناوری) اعتقادی ناگفته و درونی دربارۀ سازوکار هوش دارند: چیز مرموزی به نام هوش وجود دارد که اگر بهرهای بیشتر از آن داشته باشید، صاحب قدرت و نفوذ میشوید. ولی علمِ شناختی چنین تصویری از هوش ارائه نمیدهد و یک مجموعۀ بسیار متنوع از قابلیتهای شناختی را ارائه میکند که یکدیگر را متوازن میسازند. پس، مهارت در یک چیز سبب میشود در چیزی دیگر قابلیتی نداشته باشید. همانطور که ملانی بیان کرد، یکی از نکات بسیار قابلتوجه درمورد الگوهای زبانی بزرگ این است که چیزی مثل دستور زبان را، که سابقاً فکر میکردیم مستلزم نوعی هوش مستقلِ الگوساز است، میشود از الگوهای آماری دادهها به دست آورد. الگوهای زبانی بزرگ نمونهای هستند که نشان میدهند از انتقال و استخراج صِرف اطلاعات افراد دیگر چه میآموزیم و بررسی و کاوشگری مستقل و زندگی در جهان نیازمند چه چیزهایی است.

کراکت: شما فکر میکنید الگوهای زبانی بزرگ که فقط آموزش زبانی میبینند چه محدودیتهایی دارند؟

میچل: با توجه به اینکه زبان رسانهای غنی و فراگیر و حامل دادههای فراوان است، خطرناک است که بگوییم الگوهای زبانی بزرگ نمیتوانند از عهدۀ کاری برآیند. مثلاً، اخیراً تلاش کردهاند از الگوهای زبانی بزرگ برای کنترل رباتها استفاده کنند. بهنظرم با الگوهای زبانی بزرگ نمیشود رباتهایی ساخت که بتوانند فعالیتهای عینی انجام دهند، مثل تاکردن لباس یا هرچیزی که مستلزم مهارتهای حرکتی و فهم سازوکارهای مبنایی جهان باشد.

گوپنیک: مثلاً اگر به فیلمهای بهترین رباتهایی که میسازند نگاه کنید، گوشۀ تصویر عدد کوچکی درج شده، مثل ۱۰x یا ۲۰x یا چیزی از این دست، که نشان میدهد فیلم را روی دور تند گذاشتهاند تا کارهای رباتها بهنظر هوشمندانه برسند. اگر رباتها را در حالت طبیعیشان ببینید، بسیار کُند و ناشی به چشم میآیند و دائم اشتباه میکنند. این قضیه مصداق بارز «پارادکسِ موراوِک»5 است: چیزی که تصور میشود برای هوش مصنوعی بسیار بسیار دشوار باشد و هوش فراوانی بطلبد، مثل بازی شطرنج، نسبتاً آسان از کار درمیآید. و چیزهایی که ظاهراً هر بچۀ دوسالهای هم میتواند انجام دهد، مثل برداشتن چیزی و گذاشتن در ظرف و تکاندادن، واقعاً دشوار میشود. الگوهای زبانی بزرگ این پارادکس را برجستهتر کردهاند.

اما اگر به بحث تفاوت انواع هوش برگردیم، یک نوعِ آن را هوش انتقالی نامگذاری کردهام: ما چطور به افراد دیگر اطلاعات میدهیم و از آنها اطلاعات میگیریم؟ یک نوع دیگر آن هوشِ حقیقتیاب است: ما در جهان هستیم و جهان همواره در حال تغییر است -آنچه اهالی هوش مصنوعی «محیط ناایستا» 6 مینامند- پس ما چطور حقیقت چیزهایی را که قبلاً ندیدهایم درمییابیم؟ علم نمایانترین مصداق چنین چیزی است، ولی حتی کودکان کمسال هم در این زمینه مهارت دارند. الگوهای زبانی بزرگ در این مورد آموزش ندیدهاند. ما از «توهم» آنها حرف میزنیم، ولی توهم خیلی کلمۀ مناسبی نیست. دچار توهم شدن یعنی کسی فرق میان حقیقت و حرفِ مردم را بداند. الگوهای زبانی بزرگ نمیتوانند چنین تمایزی را قائل شوند.

میچل: میخواهم به مردم بگویم هرچه الگوهای زبانی بزرگ میگویند درواقع توهم است. بعضی از این توهمات به دلیل دادههای آماری زبان و شکل استفادۀ ما از زبان، دست بر قضا، حقیقت دارند. ولی بخش اعظم هوشمندی ما بهدلیل تواناییمان در تأمل بر وضعیت خودمان است. ما از میزان اطمینان خود به دانشمان باخبریم. این یکی از مشکلات عمدۀ الگوهای زبانی بزرگ بوده است. آنها، جز توسل به دادههای آماری زبان، روشی برای اندازهگیری اطمینانشان از جملاتی که میسازند در دست ندارند. الگوهای زبانی بزرگ تا نتوانند جملاتشان را با شواهد واقعی مستند کنند، نمیتوانند بدانند گفتههایشان درست است یا نه.

کراکت: ملانی، این مسئله با آن چیزی که بزرگترین مشکل الگوهای زبانی بزرگ میدانی ارتباط نزدیک دارد: اینکه تکیۀ آنها بر پیوندهای آماری است، نه «مفاهیم»7. مفهوم چیست و چرا موجب محدودیت الگوهای زبانی بزرگ است؟

میچل: مفهوم عبارت از انگارۀ ذهنی جنبهای از جهان است که پایهای در حقیقت دارد. شما ممکن است مفهومی از چیزی مثل تکشاخ در ذهن داشته باشید که، هرچند در جهان واقعی حقیقت ندارد، در یک جهان داستانی دیگر حقیقت دارد. میدانیم که تکشاخ موجودی خیالی است، ولی مفهومی از آن در ذهن داریم و میتوانیم به پرسشها دربارۀ آن پاسخ دهیم. به نظر من، این انگارههای ذهنی از سازوکار جهان، که چیزی موجب ایجاد چیز دیگری میشود، «مفاهیم» هستند. و این همان چیزی است که تصور نمیکنم الگوهای زبانی بزرگ، در حد انسانها، داشته باشند یا حتی بتوانند داشته باشند.

گوپنیک: نکتۀ مهم دیگری که انگارههای ذهنی را از الگوهای آماریِ صِرف متمایز میکند این است که وقتی انگارهای ذهنی دارید، ضمناً میدانید که میتوانید صحت یا عدم صحت آن را در جهان بیرون آزمایش کنید. واقعاً میتوانیم بیرون برویم و آزمایش کنیم و دادههای درست و جدید جمعآوری کنیم تا ببینیم حق با ماست یا خیر. و مجدداً تأکید میکنم این کاری است که بچههای دوساله دائم انجام میدهند (هرچند ما به آن میگوییم «سرککشیدن در همهچیز»). بیتردید، حیوانات ذیشعور هم همین کار را میکنند. مسئله این نیست که سیستمهای هوش مصنوعی اساساً قادر به انجام این کار نیستند، بلکه الگوهای زبانی بزرگ این کار را نمیکنند.

کراکت: چطور میتوانیم کاری کنیم سیستمهای هوش مصنوعی انگارههای ذهنی ایجاد کنند؟

میچل: به نظر من این امر مستلزم دخالت در جهان و آزمایشگری و استدلالورزی به طرق مختلف است، مثلاً اینکه «اگر این کار را کرده بودم، چه میشد؟» یا «اگر اتفاق دیگری میافتاد، چه تأثیری بر چیزهای دیگر داشت؟». حیوانات که بدنشان بسیار با بدن ما فرق دارد همینطور استدلال میکنند، ولی ویژگیهای خاص بدن آنها و سامانههای حسیشان تأثیر بسیاری بر مفهومسازیشان از جهان دارد. امکان تعامل بیشتر با جهان و یادگیری، عوض جذب منفعلانۀ دادهها، بسیار مهم است. در یادگیری ماشین8، درمورد نحوۀ آموزش از اصطلاح «برنامۀ آموزشی»9 استفاده میشود. آیا فقط صفحات ویکیپدیا را در سیستمهای هوش مصنوعی سرازیر میکنید؟ یا میگذارید خودش مثل بچه رشد کند؟

گوپنیک: ما در تحقیقمان کودکان را با عاملهای مختلف دیگر مقایسه کردهایم تا ببینیم هرکدام در ایجاد برنامۀ آموزشی خود چگونه عمل میکند. اگر من وظیفهای را به شما محول کنم، مثل سطحی از یک بازی ویدئویی که قادر به اتمام آن نیستید، آیا میتوانید بفهمید چه کار سادهتری را میتوانید انجام دهید؟ مثلاً، اول باید فلان بازی سادهتر را بکنم تا وارد شوم و بعد، دستآخر، خواهم توانست سطح دشوارتر را به پایان برسانم. ما دریافتیم که کودکان بهطور شگفتانگیزی در طراحی برنامههای آموزشی مهارت دارند، ولی سیستمهای فعلی هوش مصنوعی خیر.

در موضوع تکامل، بحثی هست که میگوید پیدایش «هوش» به زمان انفجار کامبرین10 برمیگردد. پیش از انفجار، موجودات زندۀ فراوانی در کف اقیانوسها زندگی میکردند، مثل اسفنجهای دریایی که زندگی راحتی داشتند و غذایی که بالای سرشان معلق بود را مصرف میکردند. ولی پس از انفجار کامبرین، موجوداتی به وجود میآیند که چشم و دست، یا به قول زیستشناسان عملکننده11 و حسگر12، دارند. وقتی صاحب عملکننده و حسگر میشوید، میتوانید چیزهای اطراف را حس کنید و حرکت کنید؛ این نقشِ کاملاً متفاوتی به حیوان در محیط میدهد. زمانی است که حیوان مغز و سیستمهای عصبی پیدا میکند، چون برای هماهنگی عمل و احساس به مغز نیاز دارد. بعد که این حیوانات جمع شدند، دنبال طعمه گشتند و از دست شکارچیها فرار کردند. سپس، دستگاهی ادراکی پدید آمد که به دنیای بیرون متصل بود و اطلاعات را جمعآوری میکرد و دستگاهی حرکتی که به جهان بیرونی متصل بود و منشأ تغییر در آن میشد. این تشکیلات ساختار بنیادی مورد نیازِ هوشِ حقیقتیابِ مذکور را شکل داد.

تلاشهای قابل توجهی در حوزۀ رباتیک و هوش مصنوعی در زمینۀ استفاده از یادگیری تقویتی13صورت گرفته که هدفشان ساختن سیستمهایی است که به جستوجوی حقیقت میپردازند. این سیستمها عوض آنکه بکوشند فقط پاداشهایی مثل امتیاز بالاتر در بازیها را به دست آورند، تلاش میکنند اطلاعات کسب کنند یا در جهان بیرون مؤثرتر باشند. و من تصور میکنم برای دستیافتن به آن هوشی که در دورۀ کامبرین تکامل یافت، احتمالاً باید چنین مسیری را طی کنیم.

کراکت: الحاق خصایص اجتماعی، مثل هیجانات و اصول اخلاقی، به نسل بعدی رباتها و سیستمهای هوش مصنوعی چقدر اهمیت دارد؟

میچل: هوش عبارت از قابلیت استفاده از ابزارهای مختلف بهمنظور افزایش هوش است و ابزار اصلی ما آدمهای دیگر هستند. ما باید از آدمهای دیگر الگویی در ذهن داشته باشیم و بتوانیم از روی شواهد اندکی که در دست داریم بفهمیم آن افراد احتمالاً مرتکب چه عملی خواهند شد -درست همانطور که درمورد اشیای واقعیِ دنیای حقیقی میدانیم. این نظریۀ ذهن و قابلیت اندیشیدن دربارۀ آدمهای دیگر برای رباتهایی که با انسانها و رباتهای هوشمند دیگر کار میکنند ضروری است.

گوپنیک: بخشهای بسیار مهمی از هوش ما چیزهایی هستند که به نظر بسیار درونی و عاطفی میرسند، مثل عشق و مراقبت از فرزندان. مشکل کنترل را که در علوم رایانه معروف است در نظر بگیرید: از کجا میدانید اهداف هوش مصنوعی با اهداف ما یکی است؟ انسانها از وقتی تکامل پیدا کردهاند همین مشکل را داشتهاند، اینطور نیست؟ ما باید اطمینان حاصل کنیم که نسلهای بعدی انسان اهداف درستی را انتخاب میکنند. و ما میدانیم که انسانهای دیگر در محیطهای متفاوتی خواهند بود. محیط تکامل ما محیطی متغیر بود. وقتی میدانید که محیط متغیر است، ولی میخواهید اعضای دیگرِ گونههای شما متحد و یکپارچه بمانند، چه میکنید؟ مراقبت یکی از کارهایی است که برای تحقق آن انجام میدهید. هر نسل تازهای از کودکان که به عرصه میرسند، ما با این مشکل برخورد میکنیم که این هوشها از راه رسیدهاند، آنها تازهاند، متفاوتاند و در محیطی دیگرند؛ از کجا میتوانیم بدانیم که اهداف درستی را برگزیدهاند؟ درمورد رابطۀ ما با هوشهای مصنوعیِ در حال پیشرفت مراقبت میتواند استعارۀ خوبی باشد.

کراکت: الیسن، شما در گفتوگویی که اخیراً با تِد چیانگ دربارۀ رمان کوتاه او با عنوان چرخۀ زندگیِ اشیای نرمافزاری(۲۰۱۰) 14داشتید به این مفهوم مراقبت اشاره کردید. کدام جنبههای اثر چیانگ به نظر شما جالب بود و چه نقاط مشترکی بین آنها و نظرات شما وجود دارد؟

گوپنیک: مثل همیشه رماننویسها بهتر از ما دانشمندان مطلب را منتقل میکنند. ماجرای این داستان علمیتخیلیِ جالب افرادی است که تلاش میکنند عاملهای هوش مصنوعی را مثل بچههایشان بزرگ کنند. داستان دشواریهای بسیار پیچیدۀ والدین انسانِ این سیستمها را شرح میدهد و تلاش هوشهای مصنوعی برای تقلید از والدینشان و یافتن راه خودشان را به تصویر میکشد. این رمان واقعاً بهترین شرحی بود که از والدگری خوانده بودم. من تصور نمیکنم درحالحاضر در مرحلهای باشیم که سیستمهای هوش مصنوعی را مثل انسان بزرگ کنیم. ولی تفکر درمورد این امکان فهمی از ارتباط آیندۀ ما با سیستمهای مصنوعی به دست میدهد. تصویری که اغلب ارائه میشود این است که هوش مصنوعی یا بردۀ ماست یا ارباب ما، ولی به نظر نمیرسد که این طرز تلقی درست باشد. اغلب سؤال میکنیم که آیا آنها مثل ما هوشمندند؟ این نوع رقابت بین ما و هوش مصنوعی وجود دارد. ولی روش منطقیتر تفکر دربارۀ هوش مصنوعی این است که آن را نوعی مکمل فناورانه بدانیم. خیلی جالب است که هیچکس نگران ماشینحسابهایی که در جیبهایمان است و مشکلات را فوراً حل میکند نیست. ما از وجودشان احساس خطر نمیکنیم. عموماً اینطور تصور میکنیم که با وجود ماشینحساب، ریاضیاتم بهتر است.

میچل: اوایل که این فناوریها بیرون آمده بودند، غالباً مردم اظهار نگرانی میکردند، چون تصور میکردند آنها به طریقی به ما آسیب میزنند. ماشینحساب که اختراع شد، مردم نمیخواستند بچهها استفاده کنند، چون فکر میکردند ماشینحساب باعث میشود بچهها ریاضی یاد نگیرند. ولی وقتی بفهمیم این فناوریها برای چه کاری مناسباند، استفاده از آنها را یاد میگیریم. درمورد هوش مصنوعی نیز همین اتفاق خواهد افتاد. هوش مصنوعی نوع جدیدی از فناوری خواهد بود که، درست مثل فناوریهای دیگر، به طرق مختلف موجب رشد و توسعۀ ما خواهد شد، ولی قرار نیست جایگزین ما شود. قرار نیست همۀ شغلها را بگیرد، چون اصلاً چنین چیزی نیست. هوش مصنوعی ویژگیهای لازم برای گرفتن جای انسانها را ندارد.

گوپنیک: ولی ما باید همچنان روی ضوابط و مقرراتِ کار با سیستمهای هوش مصنوعی بسیار دقت کنیم. مثالی که در این مورد میخواهم ذکر کنم این است که فرض کنید سال ۱۸۸۰ است و کسی میگوید بسیار خوب! برق را اختراع کردهایم که میدانیم ممکن است خانههای مردم را به آتش بکشد، ولی فکر میکنم بهتر است یک شاخه از آن را به تمام خانهها بکشیم. اگر چنین نظری مطرح میشد، ممکن بود بسیار خطرناک باشد. و همینطور هم هست -کاری بسیار خطرناک است. و فقط به دلیل مقررات فراوانی که در این زمینه داریم امکان استفاده از برق وجود دارد. تردیدی نیست که مجبور بودهایم همین کار را درمورد فناوریهای فرهنگی هم انجام دهیم. چاپ که ابداع شد، مقرراتی برای آن وجود نداشت. اطلاعات غلط و نوشتههای افتراآمیز و چیزهای مسئلهدار فراوانی چاپ شدند. تدریجاً سروکلۀ روزنامهها و سردبیرها پیدا شد. فکر میکنم همین درمورد هوش مصنوعی هم صادق خواهد بود. فعلاً، کار هوش مصنوعی تولید بدونِ ترتیب متن و تصویر است. و اگر قرار باشد از آن استفادۀ مؤثر کنیم، باید همان ضوابط و مقرراتی را که برای سایر فناوریها وضع کردهایم برای آنها نیز برقرار سازیم. ولی اینکه میگوییم رباتها قرار نیست جای ما را بگیرند به این معنی نیست که نباید نگران چیزی باشیم.

کراکت: آیا شما از سرعت کاربست ابزارهای هوش مصنوعی، مثل چتجیپیتی، متعجب شدهاید؟

میچل: بستگی دارد منظور شما از کاربست چه باشد. مردم از چتجیپیتی استفاده میکنند، ولی برای چه کاری؟ من دقیق نمیدانم که مردم چقدر از چتجیپیتی مثلاً در کارهایشان استفاده میکنند. فکر میکنم برای کارهایی مثل کدنویسی واقعاً مفید باشند. ولی بینقص نیستند -باید راستیآزمایی شوند.

گوپنیک: به نظر من، بهجای تمرکز بر داستان مهیّجِ پیشرفتهای اخیر هوش مصنوعی و ابزارهایی چون چتجیپیتی، باید به انقلاب دیجیتال حوالی سال ۲۰۰۰ توجه کنیم که نادیده گرفته شده است. این تحولی است که هنوز با آن روبهرو هستیم. اما چون بیستسی سال پیش اتفاق افتاده، آن را بدیهی فرض میکنیم. در یک مقالۀ فوقالعاده از مجلۀ سایکولاجیکال ساینس پژوهشگران از مردم پرسیدند که فلان فناوریِ متعلق به فلان سال چقدر مضر است. پژوهشگران بسیار هوشمندانه تاریخ اختراع فناوری را به تاریخ تولد افراد وصل کردند. کاشف به عمل آمد که اگر فناوری بیش از دو سال بعد از تولد افراد ابداع شده باشد، بسیار محتمل است افراد آن را مضرتر از فناوریهایی بدانند که دو سال پیش از تولدشان اختراع شده است. فرض کنید من به شما بگویم فلان فناوری سالانه میلیونها انسان را میکشد و بشریت را تهدید میکند. شما چه حسی نسبت به آن پیدا میکنید؟ بسیار خوب! این فناوری وجود دارد و نامش موتور درونسوز است. هیچکس وقتی به خودرو خود نگاه میکند با خودش نمیگوید این وسیله عجب چیز ترسناکی است. موتور درونسوز دنیا را تغییر داده و ما باید فکری به حال آن بکنیم، ولی تأثیر عاطفی این با هوش مصنوعی قابل قیاس نیست.

کراکت: ولی بسیاری از افرادِ آشنا با فناوری هستند، مثل جفری هینتون و داگلاس هافستادتر، که درمورد مسیر پیشرفت هوش مصنوعی بسیار نگراناند. شما فکر میکنید آنها درمورد کدام جنبۀ فناوری اشتباه میکنند؟

میچل: من نمیگویم که نباید نگران آن باشیم. ممکن است این فناوریها مسبب چیزهای بد فراوانی شوند. همینحالا هم شاهد اتفاقات بدی هستیم، مثل آنچه که کُری دکترو «اضمحلال اینترنت»15 نامید که اشاره به خروارها محتوای گمراهکننده دارد و روزبهروز هم بدتر میشود. مشکلِ سوگیری، حریم خصوصی و میزان احمقانۀ برق و آبی که در مراکز داده استفاده میشوند نیز هست. ولی من فکر میکنم نگرانیهای هینتون و هافستادتر متفاوتاند. هینتون نگران است سیستمها از کنترل خارج شوند، «فوقهوشمند» شوند، ما را آلت دست خود قرار دهند و عاملیت خودشان را به دست آورند. از سوی دیگر، هافستادتر بیشتر نگران انسانیتزدایی است -نگران است که چیزهایی مثل خلق موسیقی و ادبیات، که برای او بیشترین ارزش را دارند، دست رایانهها بیفتد.

من چندان نگران این خطرات فرضی نیستم، چون نشانهای نمیبینم که تهدیدها به این زودی محقق شوند. من مقالهای نوشتم با عنوان «چرا هوش مصنوعی از آنچه فکر میکنیم دشوارتر است»16و توضیح دادم که مردم همتاسازی هوش انسانی در این ماشینها را خیلی ساده فرض کردهاند. هوش انسان از اجزای بسیاری تشکیل شده که این منتقدان جزء هوش به شمار نمیآورند. برایم جالب است که دیگران هینتون را متخصص «هوش مصنوعی عمومی» میدانند، چون اصلاً چیزی بهعنوان هوش مصنوعی عمومی نداریم. هنوز هیچکس دقیقاً نمیداند هوش چیست چه برسد به اینکه بخواهند در آینده آن را در رایانهها همتاسازی کنند.

گوپنیک: به نظرم جای تقدیر دارد که برخی پیشگامان این حوزه مسئولیت فناوری را بر عهده میگیرند و تلاش میکنند به فکر آثار مخرب آن بر جهان باشند. این احساس مسئولیت، مثل حس مسئولیت رابرت اوپنهایمر، ستودنی است. و همانطور که ملانی گفت، قطعاً ممکن است اتفاقات بدی بیفتد. ولی من هم فکر میکنم کسانی که این سیستمها را طراحی میکنند دوست دارند که بگویند سیستمهایشان خیلی قدرتمندند و چیزی شبیه هوش عمومی دارند. نکتۀ جالب دیگر اینکه ما اضطراب را بیشتر در میان کسانی مشاهده میکنیم که دانشمند علوم شناختی نیستند و مطالعهای در زمینۀ هوش انسان یا حیوان نداشتهاند. تصور میکنم که بشود گفت پژوهشگران هوش انسانی همنظرند که فاصلۀ هوش انسانی و مصنوعی بسیار زیاد است و آنچه حائز اهمیت است نه تهدیدات عاملهای هوش مصنوعی، بلکه مخاطرات پیشپاافتادهتری مثل اطلاعات گمراهکننده و دیگر محتواهای بدِ موجود در اینترنت است.

کراکت: آیا شما نگران گستردگیِ تأثیر نامحسوس سیستمهای هوش مصنوعی، بهخصوص در اینترنت و از طریق تلفن همراه، بر تصمیماتمان هستید؟

میچل: در بعضی حوزههای زندگی، بله. ما برای راحتی بیشتر عاملیتمان را معامله میکنیم. مثلاً، من دوست دارم در ماشین برای جهتیابی از جیپیاس استفاده کنم. خیلی راحت است و اطمینان دارم که کار میکند. ولی نتیجه این میشود که من نقشۀ ذهنی درستی از مکانهایی که میروم ایجاد نمیکنم. این یکی از مشکلات بسیاری از این سیستمهاست -آنها کارها را بسیار ساده میکنند، ولی این سادگی هزینهای دارد که ما درست متوجه آن نیستیم. نمونههای دیگری نیز در تاریخ وجود دارد که ما برخی تواناییهایمان را قربانی راحتی کردهایم، مثلاً درمورد کتاب که دیگر مجبور نیستیم چیزی را به خاطر بسپاریم. اگر گوشی هوشمند داشته باشید، میتوانید همهچیز را جستوجو کنید، عوض آنکه از دیگران بپرسید یا به دایرةالمعارفها مراجعه کنید. تفویض تصمیمگیریها به الگوریتمهای هوش مصنوعی آسیبهایی به ما رسانده و اکنون نتیجۀ آن را در اوضاع جاری جهان مشاهده میکنیم.

گوپنیک: هنری فارل، دانشمند علوم سیاسی، گفته که ما قبلاً هوشهای مصنوعی را به صورت بازارها و دولتها داشتهایم. هر بازاری یک دستگاه عظیم پردازش اطلاعات و تصمیمگیری است. پس هر زمان میبینم قیمت چیزی ۴ دلار و ۹۹ سنت است و آن را میخرم، بخشی از استقلالم را تسلیم قدرت بازار میکنم، اینطور نیست؟ اگر من مثلاً در میان اقوام شکارچی-گردآورنده زندگی میکردم، چنین رفتاری را نشان نمیدادم. ما به سیستمهای عظیم پردازش اطلاعات، مثل بازارها، دولتها و بوروکراسیها، تکیه میکنیم و تصمیمگیری فردی را کنار میگذاریم. سیستمهای حقوقی هم همینطورند. من تصمیم نمیگیرم چه زمانی از خیابان عبور کنم؛ چراغ راهنما میگوید آیا من مجاز به عبور هستم یا خیر. و مجدداً تأکید میکنم این سیستمها محسناتی دارند و موجب هماهنگی و نظم مردم در جوامع اجتماعی بزرگ میشوند، ولی معایبی نیز دارند. آنها ممکن است جریان و حیاتی مستقل از همۀ کسانی که درموردشان تصمیم میگیرند داشته باشند. پس وقتی میگوییم کشور تصمیم گرفته حمله کند یا میگوییم بازار سقوط کرده، درواقع نتیجۀ تصمیم فردی تعداد زیادی آدم است، ولی این سیستمهای تصمیمگیریِ فوقفردی در سراسر تاریخ بشر حیات خود را داشتهاند.

میچل: این قضیه من را یاد طرح «فاجعۀ گیرۀ کاغذِ»17 نیک بوستروم میاندازد که یک سیستم هوش مصنوعیِ فوقهوشمند رفتاری جامعهستیزانه نشان میدهد: برایش هدفگذاری میشود و او برای رسیدن به آن هدف هر کاری میکند و اهمیتی به پیامدهای اَعمال خود نمیدهد. تد چیانگ در مقالهای نوشت که همینحالا هم چیزهایی داریم که مثل همین رفتار میکنند: نام آنها شرکتهای تجاری است و هدفشان بهحداکثررساندن ارزش سهام است. به نظر من به همین دلیل است که اهالی سیلیکون ولی اکثراً نگران کارهای هوش مصنوعی هستند. بهحداکثررساندن ارزش سهام شرکتها استعارهای است که آنها برای تفکر دربارۀ سیستمهای هوش مصنوعی استفاده میکنند.

گوپنیک: به نظر من ملانی کاملاً درست میگوید. موضوع همین استعارههاست. استعارههایی که درمورد سیستمهای هوشمند استفاده میشوند اکثراً استعارههایی هستند که بیشترین نیرو و منابع را میطلبند. پس اگر ما هوش مصنوعی هوشمند داشته باشیم، چنین کاری خواهد کرد. اما از منظر تکاملی، اصلاً چنین چیزی رخ نمیدهد. چیزی که ما در سیستمهای هوشمندتر مشاهده میکنیم همکاری و علقههای اجتماعیِ بیشتر است. مغز بزرگ مستلزم چنین چیزی است: آنها کودکی طولانیتری دارند و افراد بیشتری از کودکان مراقبت میکنند. در اکثر موارد، وقتی دربارۀ سازوکار سیستمهای هوشمند فکر میکنیم بهتر است که در نظر بگیریم آنها تلاش میکنند همسانایستایی18 را حفظ کنند. سیستم تلاش میکند ثبات و بقای خود را تضمین کند، نه اینکه تا جای ممکن منابع را تصاحب کنند. حتی میگوی کوچک اقیانوس هم تلاش میکند غذای کافی برای زندهماندن به دست آورد و از شکارچیان فرار کند. میگو با خودش نمیگوید که آیا میتوانم کریلهای کل اقیانوس را بخورم؟ این شکلِ سیستمهای هوشمند با تصور ما از سازوکار سیستمهای هوشمند فرق دارد.

کراکت: آیا کار بر روی هوش مصنوعی بر شناخت شما از خودتان تأثیر گذاشته است؟

میچل: جان مککارتی، یکی از پیشگامان هوش مصنوعی و یکی از شرکتکنندگان «ورکشاپ ۱۹۵۶ دارتموث» که تصور میکرد ما در طول یک تابستان پیشرفت بزرگی خواهیم کرد، بعدها گفت که «هوش از آنچه تصور میکردیم دشوارتر بود». من هم بهتدریج چنین دیدگاهی پیدا کردم. و باعث شده بیشتر و بیشتر با متخصصان علم شناختی، مثل الیسن، در این مورد صحبت کنم. من معتقدم پژوهش درمورد هوش مصنوعی باید عوض اعتلای فنون بهینهسازی، مجدداً تمرکز خود را به فهم ماهیت هوش معطوف کند.

گوپنیک: من روانشناس رشد هستم و بخش اعظم اوقاتم را با بچههای کوچک میگذرانم. آنها بینهایت از آنچه تصور میکنیم باهوشترند. کار با هوش مصنوعی باعث شده حتی بیشتر تحتتأثیر کارهایی که بچههای دوساله انجام میدهند قرار بگیرم. همچنین سبب شده هوش اختاپوسها، میگوهای اقیانوس و موجودات دیگرِ اطرافمان برجستهتر جلوه کند. از سوی دیگر، من اصلاً تصور نمیکردم تا این اندازه بتوانیم فقط از منابعِ متنی بیاموزیم. سؤالی که مطرح میشود این است که چه میزان از آنچه تصور میکنم دانش عمیق خودم از جهان است تکرار طوطیوار چیزهایی است که خواندهام یا از زبان مردم شنیدهام؟ الگوهای زبانی بزرگ این مسئله را به طریق بسیار جالبی مطرح کردهاند.

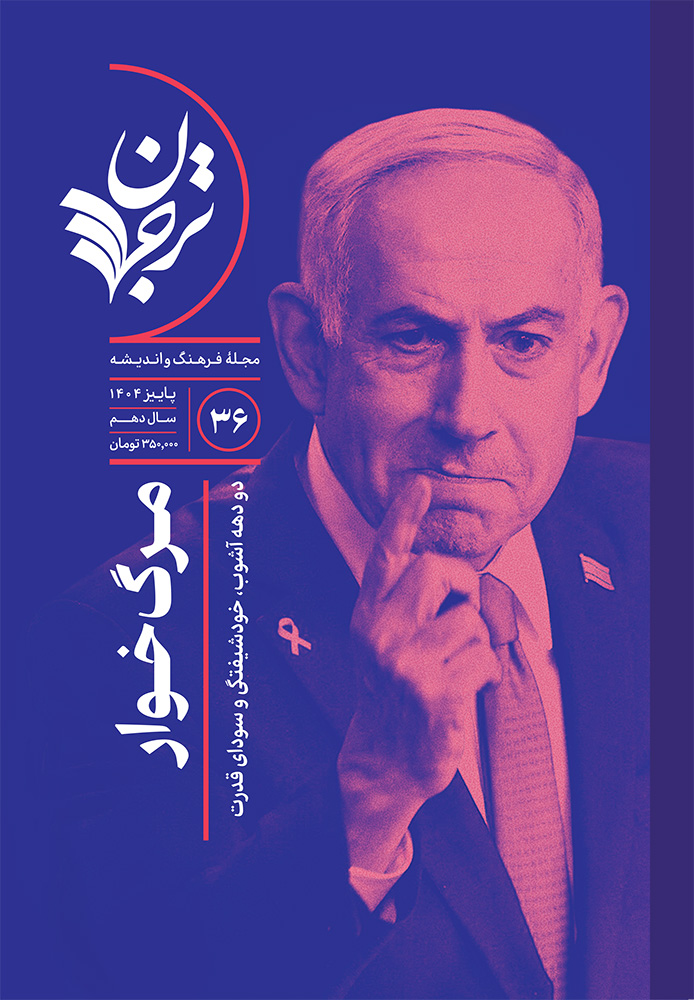

فصلنامۀ ترجمان چیست، چه محتوایی دارد، و چرا بهتر است اشتراک سالانۀ آن را بخرید؟

فصلنامۀ ترجمان شامل ترجمۀ تازهترین حرفهای دنیای علم و فلسفه، تاریخ و سیاست، اقتصاد و جامعه و ادبیات و هنر است که از بیش از ۱۰۰ منبع معتبر و بهروز انتخاب میشوند. مجلات و وبسایتهایی نظیر نیویورک تایمز، گاردین، آتلانتیک و نیویورکر در زمرۀ این منابعاند. مطالب فصلنامه در ۴ بخش نوشتار، گفتوگو، بررسی کتاب، و پروندۀ ویژه قرار میگیرند. در پروندههای فصلنامۀ ترجمان تاکنون به موضوعاتی نظیر «اهمالکاری»، «تنهایی»، «مینیمالیسم»، «فقر و نابرابری»، «فرزندآوری» و نظایر آن پرداختهایم. مطالب ابتدا در فصلنامه منتشر میشوند و سپس بخشی از آنها بهمرور در شبکههای اجتماعی و سایت قرار میگیرند، بنابراین یکی از مزیتهای خرید فصلنامه دسترسی سریعتر به مطالب است.

فصلنامۀ ترجمان در کتابفروشیها، دکههای روزنامهفروشی و فروشگاه اینترنتی ترجمان بهصورت تک شماره به فروش میرسد اما شما میتوانید با خرید اشتراک سالانۀ فصلنامۀ ترجمان (شامل ۴ شماره)، علاوه بر بهرهمندی از تخفیف نقدی، از مزایای دیگری مانند ارسال رایگان، دریافت کتاب الکترونیک بهعنوان هدیه و دریافت کدهای تخفیف در طول سال برخوردار شوید. فصلنامه برای مشترکان زودتر از توزیع عمومی ارسال میشود و در صورتیکه فصلنامه آسیب ببیند بدون هیچ شرط یا هزینۀ اضافی آن را تعویض خواهیم کرد. ضمناً هر وقت بخواهید میتوانید اشتراکتان را لغو کنید و مابقی مبلغ پرداختی را دریافت کنید.

این مطلب گفتوگویی است با ملانی میچل و الیسن گوپنیک در تاریخ ۳۱ می ۲۰۲۴ با عنوان «How to Raise Your Artificial Intelligence: A Conversation with Alison Gopnik and Melanie Mitchell» در وبسایت لسآنجلس ریویو آو بوکس منتشر شده است و برای نخستینبار در تاریخ ۶ آبان ۱۴۰۳ با عنوان «چرا نباید از هوش مصنوعی ترسید؟» و با ترجمۀ عرفان قادری در وبسایت ترجمان علوم انسانی منتشر شده است.

ژولیئن کراکت (Julien Crockett) وکیل حق مالکیت معنوی و ویراستار علمی و حقوقیِ لسآنجلس ریویو آو بوکس است.

ملانی میچل (Melanie Mitchell) استاد انستیتو سانتا فه است. حوزۀ فعلی پژوهشهای او انتزاع مفهومی و قیاس در سیستمهای هوش مصنوعی است. از او تاکنون شش کتاب و چندین مقالۀ پژوهشی در زمینۀ هوش مصنوعی، علم شناختی و سیستمهای پیچیده منتشر شده است. کتاب او با عنوان Complexity: A Guided Tour (2009) برندۀ جایزۀ Phi Beta Kappa Science Book Award شد و کتاب Artificial Intelligence: A Guide for Thinking Humans (2019) او به فهرست نهایی جایزۀ Cosmos Prize راه یافت.

الیسن گوپنیک (Alison Gopnik) از سال ۱۹۸۸ استاد روانشناسی و فلسفۀ دانشگاه کالیفرنیا بوده است. او یکی از پیشگامان علم شناختی، بهخصوص در زمینۀ مطالعۀ آموزش و رشد کودکان، به شمار میآید. از او تاکنون بیش از صد مقاله و چندین کتاب منتشر شده است، از جمله کتابهای پرفروشی چون The Scientist in the Crib (1999) ،The Philosophical Baby: What Children’s Minds Tell Us About Love, Truth and the Meaning of Life (2009). انتشارات ترجمان کتاب تحسینشدۀ The Gardener and the Carpenter: What the New Science of Child Development Tells Us About the Relationship Between Parents and Children (2016) این نویسنده را با عنوان علیه تربیت فرزند ترجمه و منتشر کرده است.

پاورقی

-

1

large language model (LLM)

-

2

complexity

-

3

autocomplete

-

4

برای اطلاعات بیشتر در این مورد به مطلب «شما طوطی نیستید، چتجیپیتی هم انسان نیست» در بیستوهشتمین فصلنامۀ ترجمان علوم انسانی مراجعه کنید[مترجم].

-

5

Moravec’s paradox

-

6

nonstationary environment

-

7

concepts

-

8

machine learning

-

9

curriculum

-

10

Cambrian explosion: رویداد فرگشتی نسبتاً کوتاهی بود که در آغاز دورهٔ کامبرین، نزدیک به ۵۴۲ میلیون سال پیش، رخ داد که در طی آن بسیاری از شاخههای اصلی حیوانات پدید آمدند [مترجم].

-

11

actuator

-

12

sensor

-

13

reinforcement learningیا یادگیری تقویتی یا یادگیری پاداش و تاوان، یکی از گرایشهای یادگیری ماشینی است که از روانشناسی رفتارگرایی الهام میگیرد. این روش بر رفتارهایی تمرکز دارد که ماشین باید برای بیشینهکردن پاداشش انجام دهد[مترجم].

-

14

The Lifecycle of Software Objects

-

15

enshittification of the internet

-

16

Why AI Is Harder Than We Think

-

17

Paperclip apocalypse

-

18

Homeostasisفرایندی فیزیولوژیکی است که نظامهای درونی بدن را بهرغم تغییرات شرایط خارجی متعادل نگه میدارد [مترجم].

مرتبط

چطور شبهعلمِ «زبان بدن» شبکههای اجتماعی را تسخیر کرد؟

متخصصان یوتیوبی با تحلیل بدن سیاستمداران و سلبریتیها بهدنبال کشف حقیقتاند، آیا موفق میشوند؟

با زردچوبه به جنگ سرطان بروید (اگر میتوانید)

چطور دستهای از متخصصان رسانهای تغذیه، بر اساس تحقیقات علمی، ادعاهای نادرست میکنند؟

خاستگاههای ایتالیایی مکتب فرانکفورت

هنگامی که گروهی از روشنفکران آلمانی به ناپل رسیدند، با شیوهای از زندگی مواجه شدند که آنها را به بازاندیشی دربارۀ مدرنیته واداشت

زندگی فلسفی با زندگی غیرفلسفی چه تفاوتی میکند؟

ذهن سزاوار وظیفهای است که درخور تواناییهایش باشد