ما در برابر روباتها مسئولیت اخلاقیِ بیشتری داریم

اگر بتوانیم روباتهای هوشمند بسازیم، مسئول غم و شادیهایشان نیز خواهیم بود

فرض کنید سال ۲۱۰۰ است و بالاخره انسانها موفق شدهاند روباتهایی بسازند که سطحِ هوشمندی و خلاقیت آنها در حد انسانها باشد. این روباتها، با آن سطح از آگاهی و عواطف و احساساتی که خواهند داشت، رنج خواهند کشید و لذت خواهند برد. اگر چنین اتفاقی ممکن شود، آنگاه وظایف ما در برابر موجوداتی که خلق کردهایم چیست؟ آیا میتوان گفت ما دربرابر این روباتها مسئولیت اخلاقی داریم؟

اریک شویتسگبل، ایان — روباتِ هاتبات فوربی از دهانۀ آتشفشان بهسوی اعماق آن پایین میرود. سال ۲۰۵۰ یا ۲۱۵۰ است و هوش مصنوعی بهاندازۀ کافی پیشرفت کرده است که بتوان روباتهایی با هوش، خلاقیت و آرزوهایی همتراز انسان ساخت. هاتبات در حین این مأموریتِ علمی نابود خواهد شد. آیا این روبات حق و حقوقی دارد؟ آیا ما با دستوردادن به آن برای رفتن به اعماق آتشفشان، از نظر اخلاقی، کار نادرستی انجام دادهایم؟

شأن اخلاقی روباتها مضمونی رایج در داستانهای علمیتخیلی است که حداقل به داستانهای آیزاک آسیموف دربارۀ روباتها باز میگردد و اتفاقنظر در این زمینه آشکار است: اگر ما در آینده موفق شویم روباتهایی بسازیم که حیات ذهنی آنها همانند ما باشد -یعنی با برنامهها و آرزوهایی انسانگونه و ادراکی از خویشتن، شامل تواناییِ ادراکِ شادی و رنج- در این صورت، آن روباتها شایستۀ ملاحظاتی اخلاقی همانند آنهایی خواهند بود که درمورد انسانهای معمولی رعایت میشود. فیلسوفان و پژوهشگرانِ هوش مصنوعی، که دربارۀ این موضوع قلمفرسایی کردهاند، بهطور کلی در این زمینه اتفاقنظر دارند.

من میخواهم این اتفاقنظر را به چالش بکشم، اما نه بهشیوهای که شاید شما پیشبینی کنید. از دیدگاه من، اگر ما در آینده روباتهایی با تواناییهای عاطفی و شناختیِ انسانگونه بسازیم، نسبتبه آنها ملاحظات اخلاقی بیشتری بر عهده خواهیم داشت تا آنچه بهطور عادی باید نسبتبه انسانهای معمولی رعایت کنیم.

دلیل آن این است: ما خالق و طراح آنها خواهیم بود. بنابراین ما، بهطور مستقیم، هم در قبال بهوجودآمدن آنها مسئول هستیم و هم در قبال شادی و ناشادی آنها. اگر روباتی بیجهت رنج بکشد یا از رسیدن به کمالِ رشد خود بازبماند، بخش اعظم این امر ناشی از کوتاهی ما خواهد بود: کوتاهی در آفرینش، طراحی یا پرورش آن. رابطۀ اخلاقی ما با روباتها، بیشتر از آنکه شبیه رابطۀ بین انسانهای غریبه باشد، همانند رابطۀ والدین با فرزندان خود یا رابطۀ خدایان با مخلوقات خود است.

بهتعبیری، این چیزی بیش از برابری نیست. اگر من موقعیتی ایجاد کنم که دیگران را با خطر روبهرو میکند، برای مثال، اگر کشتزارهای آنها را برای ساخت فرودگاه نابود کنم، در این صورت، وظیفۀ اخلاقی من برای جبران خسارتِ آنها بزرگتر از وظیفۀ من در برابر افرادی خواهد بود که هیچ ارتباط علّیای با آنان ندارم. اگر روباتهایی بسازیم که واقعاً آگاه باشند، عمیقاً از نظر علّی با آنها پیوند خواهیم یافت و بنابراین بهطور بنیادی در قبال سعادت آنها مسئول خواهیم بود. این ریشۀ وظیفۀ خاص ماست.

هیولایِ فرانکنشتاین به خالق خود، ویکتور فرانکنشتاین، چنین میگوید:

من مخلوق تو هستم و همیشه نسبتبه پادشاه و سَرور طبیعی خود با مهربانی و فرمانبرداری رفتار خواهم کرد، اما بهشرطی که تو نیز وظیفۀ خود را انجام دهی و دِین خود به من را ادا کنی. آه، فرانکنشتاین، آنچنان نباش که با همه با انصاف رفتار کنی و تنها مرا نادیده بگیری و پایمال کنی، من که شایستهترین فرد برای رفتار منصفانه و حتی سزاوارترین کس برای ترحم و محبت تو هستم. به یاد داشته باش که من مخلوق تو هستم: من باید آدمِ۱ تو باشم… .

ما یا باید صرفاً روباتهایی بسازیم که بهاندازۀ کافی ساده باشند -بهنحویکه بدانیم شایستۀ ملاحظات اخلاقی نیستند، آنچنانکه این امر درمورد تمام روباتهای کنونی صادق است- یا باید آنها را محتاطانه و از روی خیرخواهی به وجود آوریم.

در کنار این وظیفۀ خیرخواهی، وظیفهای معرفتی نیز وجود دارد: دانستن اینکه کدامیک از مخلوقات ما واقعاً آگاه هستند. کدامیک از آنها دارای جریانهایی واقعی از تجربۀ ذهنی هستند و توان درکِ شادی و رنج را دارند یا میتوانند به دستاوردهای شناختی نظیر خلاقیت و ادراک خویشتن دست پیدا کنند؟ بدون چنین دانشی، نمیتوانیم بدانیم که چه وظایفی در برابر مخلوقات خود بر عهده داریم.

بااینحال، چگونه میتوانیم چنین دانشی به دست آوریم؟ برای مثال، چگونه میتوان بین جریانی واقعی از تجربۀ عاطفی و عواطف شبیهسازیشده در ذهنی مصنوعی تمایز نهاد؟ صرفاً برنامهریزیِ یک شبیهسازی سطحی از عواطفْ کافی نیست. اگر من یک پردازشگر رایانهای معمولی و محصول سال ۲۰۱۵ را در داخل یک دایناسورِ اسباببازی بگذارم و آن را طوری برنامهریزی کنم که با فشردنِ کلید خاموش بگوید «آخ!»، روباتی نساختهام که توانایی ادراک درد را داشته باشد. اما دقیقاً چه نوعی از پردازش و پیچیدگی، برای ظهور آگاهی اصیلِ انسانگونه، ضروری است؟ طبق برخی دیدگاهها، برای مثال، از دیدگاه جان سرل۲، شاید آگاهی در هیچ موجودِ برنامهریزیشدهای تحققپذیر نباشد؛ شاید آگاهی نیازمند ساختاری است که از نظر زیستشناختی شبیه مغز انسان باشد. دیگر دیدگاهها، دربارۀ شرایط کافی برای ظهور آگاهی در روبات، آزاداندیشانهتر هستند. مطالعۀ علمیِ آگاهی هنوز در دوران کودکی خود است. این مسئله هنوز بسیار جای بحث دارد.

اگر به توسعۀ صور پیچیدۀ هوش مصنوعی ادامه دهیم، وظیفۀ اخلاقی ما خواهد بود که فهم خود را، از شرایطی که تحت آن ممکن است آگاهی مصنوعی بهطور اصیل ظهور نماید، بهبود ببخشیم. در غیر این صورت، با خطر فاجعۀ اخلاقی روبهرو خواهیم بود: یا با فاجعۀ قربانیکردنِ منافعِ خود برای موجوداتی که شایستۀ ملاحظات اخلاقی نیستند زیرا شادی و رنج را تنها بهطور تصنعی تجربه میکنند یا با فاجعۀ ناتوانی از درک رنج روباتها و بنابراین بهطور ناخواسته ارتکاب ستمگریهایی برابر با بردهداری و قتل علیه موجوداتی که نسبتبه آنها تقریباً وظیفۀ مراقبتِ والدین از فرزند را بر عهده داریم.

بنابراین، وظیفۀ اخلاقی صریح ما برخورد با مخلوقات خودمان با اذعان به مسئولیت خاص خود در قبال شادی، رنج، اندیشهورزی و قدرت خلاقیت آنهاست. اما ما وظیفهای معرفتی نیز بر عهده داریم؛ ما باید بهاندازۀ کافی دربارۀ مبانی کارکردی و مادیِ شادی، رنج، اندیشهورزی و خلاقیت بیاموزیم، بهنحویکه بدانیم آیا مخلوقاتِ بالقوۀ ما در آینده شایستۀ توجه اخلاقی ما هستند یا خیر و چه زمانی باید ملاحظات اخلاقی را درمورد آنها رعایت کرد.

پینوشتها:

• این مطلب را اریک شویتسگبل نوشته است و در تاریخ ۱۲ نوامبر ۲۰۱۵ با عنوان «We have greater moral obligations to robots than to humans » در وبسایت ایان منتشر شده است. وبسایت ترجمان در تاریخ ۶ دی ۱۳۹۵ این مطلب را با عنوان «ما در برابر روباتها مسئولیت اخلاقیِ بیشتری داریم» و با ترجمۀ علی برزگر منتشر کرده است.

•• اریک شویتسگبل (Eric Schwitzgebel) استاد فلسفۀ دانشگاه کالیفرنیا در پردیس ریورساید است. او وبلاگی با نام اسپلینترد مایند دارد و پیچیدگیهای آگاهی (Perplexities of Consciousness) آخرین کتاب اوست.

[۱] Adam

[۲] John Searle: فیلسوف ذهن معاصر که معتقد است برنامههای رایانهای و بهطور کلی یک سیستم نحوی هرگز فینفسه نمیتواند معنا را در خود جای دهد [مترجم].

مرتبط

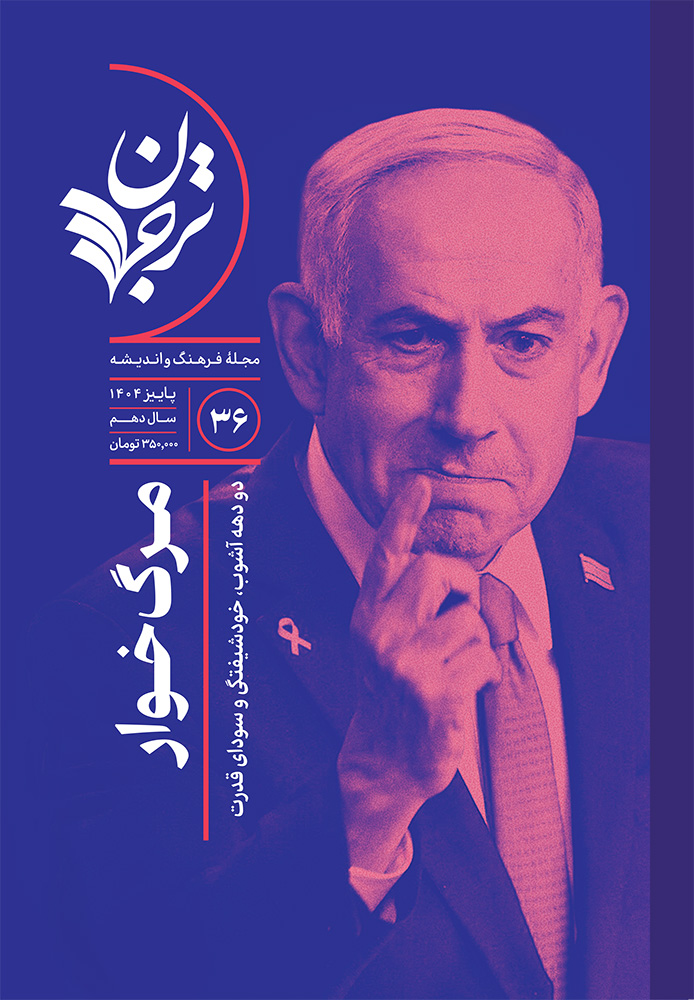

چطور شبهعلمِ «زبان بدن» شبکههای اجتماعی را تسخیر کرد؟

متخصصان یوتیوبی با تحلیل بدن سیاستمداران و سلبریتیها بهدنبال کشف حقیقتاند، آیا موفق میشوند؟

با زردچوبه به جنگ سرطان بروید (اگر میتوانید)

چطور دستهای از متخصصان رسانهای تغذیه، بر اساس تحقیقات علمی، ادعاهای نادرست میکنند؟

خاستگاههای ایتالیایی مکتب فرانکفورت

هنگامی که گروهی از روشنفکران آلمانی به ناپل رسیدند، با شیوهای از زندگی مواجه شدند که آنها را به بازاندیشی دربارۀ مدرنیته واداشت

زندگی فلسفی با زندگی غیرفلسفی چه تفاوتی میکند؟

ذهن سزاوار وظیفهای است که درخور تواناییهایش باشد